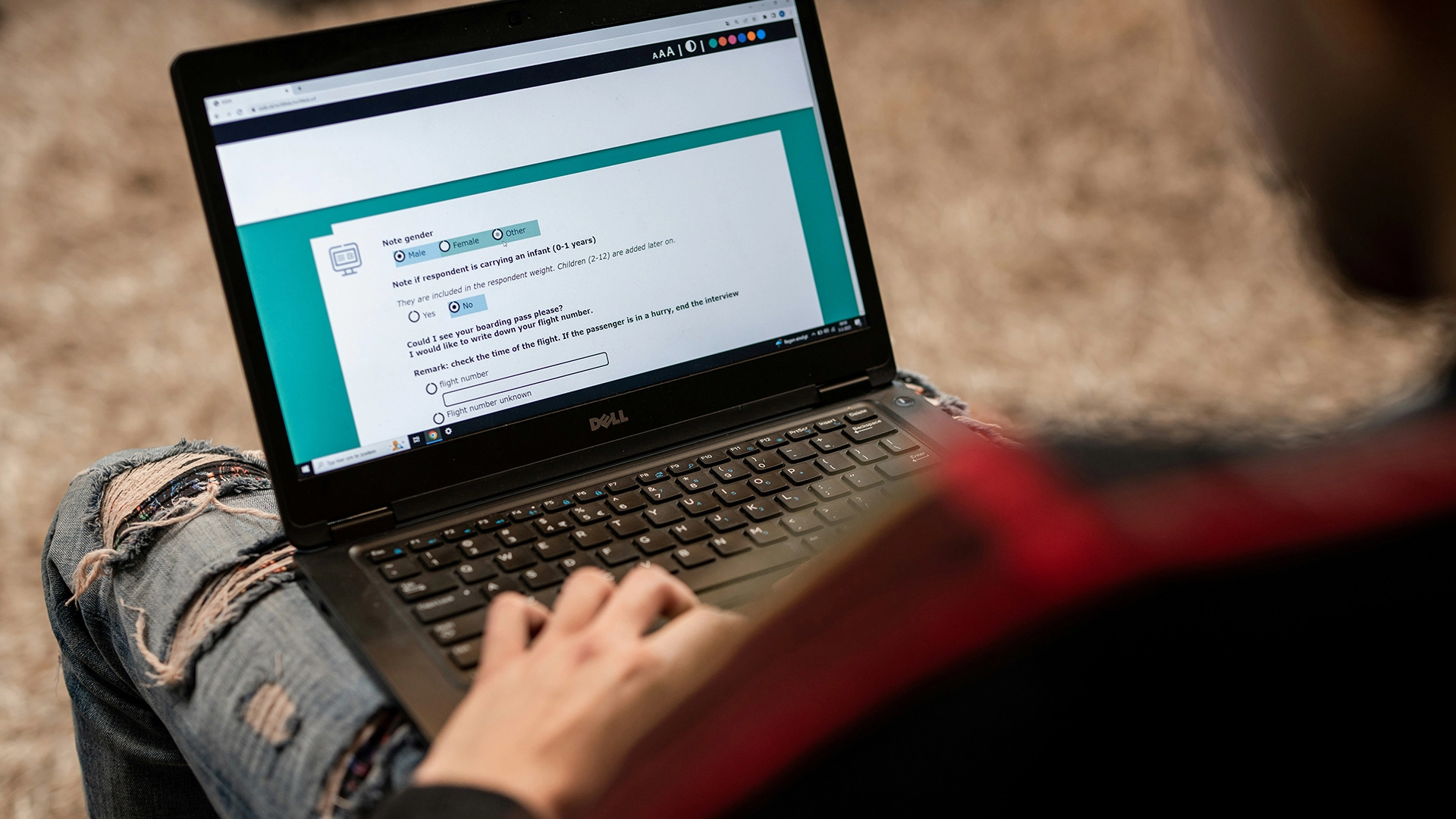

Image by ODISSEI, from Unsplash

Badania Wykazują, że Prawie Połowa Odpowiedzi w Ankietach Online Może Pochodzić od Sztucznej Inteligencji

Badania nad zachowaniem online, które wcześniej były uważane za wiarygodną metodę badania psychologii człowieka, teraz napotykają na poważny problem, gdy uczestnicy korzystają z narzędzi AI, takich jak chatboty, do generowania swoich odpowiedzi.

W pośpiechu? Oto szybkie fakty:

- 45% uczestników ankiety Prolific wkleiło odpowiedzi generowane przez AI.

- Badacze odkryli, że teksty chatbotów często wyglądają na „zbyt rozwlekłe” lub „nie-ludzkie”.

- Eksperci nazywają ten problem „Zanieczyszczeniem LLM”, co zagraża wiarygodności badań behawioralnych.

Naukowcy z Max Planck Institute for Human Development w Berlinie niedawno zbadali, jak powszechny jest problem na platformach takich jak Prolific, które płacą wolontariuszom za wypełnianie ankiet.

„Współczynniki występowania, które obserwowaliśmy, były naprawdę szokujące” – mówi główna badaczka, Anne-Marie Nussberger, jak donosi New Scientist (NS).

W jednym z testów, 45 procent uczestników wydawało się wklejać treści generowane przez chatboty do pól na otwarte odpowiedzi. Odpowiedzi często wykazywały takie oznaki jak „nadmiernie rozwlekłe” lub „wyraźnie nie-ludzkie” językowe formy.

„Na podstawie danych, które zebraliśmy na początku tego roku, wydaje się, że znaczna część badań jest skażona”, powiedziała Nussberger do NS.

Aby wykryć podejrzane odpowiedzi, jej zespół wprowadził ukryte pułapki. Podstawowe reCAPTCHAs oznaczyło 0,2 procent użytkowników, bardziej zaawansowana wersja złapała 2,7 procent, niewidoczny tekst zachęcający do wpisania słowa „hazelnut” schwytany 1,6 procent, a zakazanie kopiowania i wklejania ujawniło kolejne 4,7 procent.

Problem ewoluował do tego, co eksperci obecnie nazywają „Zanieczyszczeniem LLM”, które wykracza poza kwestię oszustwa. Badanie naukowe ujawnia trzy wzorce ingerencji AI: Częściową Mediację (AI pomaga w sformułowaniu lub tłumaczeniu), Pełną Delegację (AI przeprowadza kompleksowe badania) oraz Spillover (ludzie modyfikują swoje działania, ponieważ przewidują obecność AI).

“To, co musimy zrobić, to nie nie ufać całkowicie badaniom online, ale odpowiedzieć i zareagować,” mówi Nussberger, wzywając platformy do poważnego potraktowania problemu, jak podaje NS..

Matt Hodgkinson, konsultant ds. etyki badań, ostrzega w rozmowie z NS: „Wiarygodność badań nad zachowaniami online już była kwestionowana […] Badacze muszą albo wspólnie opracować metody zdalnego potwierdzania udziału ludzi, albo wrócić do staromodnego podejścia polegającego na bezpośrednim kontakcie twarzą w twarz.”

Firma Prolific odmówiła komentarza dla NS.

Poprzedni artykuł

Poprzedni artykuł

Najnowsze artykuły

Najnowsze artykuły